yandex研发团队与来自ist austria、neuralmagic和kaust的研究人员合作,开发了两种针对大型语言模型的创新压缩方法:语言模型的加性量化 (aqlm)和 pv-tuning。这两种方法结合使用时,可将模型大小减少多达8倍,同时保持95%的响应质量。这些方法旨在优化资源,并提高运行大型语言模型的效率。详细介绍此方法的研究文章已在近期在奥地利维也纳举行的国际机器学习大会 (icml)上发表。

aqlm和 pv的主要特点

在消费类硬件上部署大型语言模型是具有挑战性的,因为模型大小和计算效率之间存在固有的权衡。量化等压缩方法提供了部分凯发k8官网的解决方案,但往往会影响模型性能。

aqlm利用传统上用于信息检索的加性量化来进行大型语言模型的压缩,可将每个模型参数的比特数减少到2-3比特,该方法可在极端压缩的情况下保持甚至提高模型的准确性,从而使得在家用电脑等日常设备上部署大型语言模型成为可能。这也显着减少了内存消耗。aqlm的关键创新包括权重矩阵的学习加性量化,以适应输入的可变性,以及对跨层块的码本参数进行联合优化。这种双重策略使 aqlm能够超越其他压缩技术,在该领域树立了新的基准。

pv- tuning是一个与表示无关的框架,它概括并改进了现有的微调策略,可解决模型压缩过程中可能出现的错误。pv-tuning在有限情况下提供收敛保证,并且在 llama和 mistral等高性能模型上用于1-2位矢量量化时,其性能已被证明优于以前的方法。通过利用 pv-tuning,研究人员首次实现了 llama 2模型每个参数 2比特的帕累托最优量化。

当aqlm和 pv-tuning结合使用时,可获得最佳结果——即使在有限的计算资源下,也能提供高质量响应的紧凑模型。

方法评估与认可

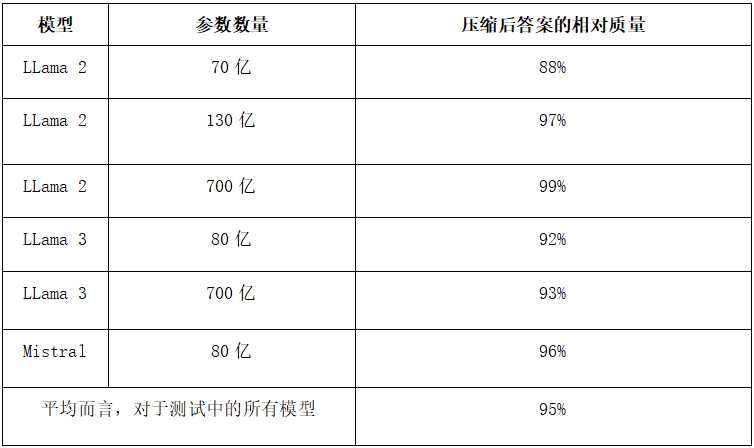

研发团队使用llama 2、llama 3、mistral等流行的开源模型,对这些方法的有效性进行了严格评估。研究人员通过对这些大型语言模型进行压缩,并根据英语基准(wikitext2和 c4)评估答案质量,在模型压缩8倍的情况下,仍获得了令人印象深刻的95%的答案质量。

*测试中答案的平均准确度越接近原始模型,新方法在保持答案质量方面就越好。上图的数字显示了两种方法的综合结果,模型平均压缩了 8倍。

aqlm的实用性还通过其在 gpu和 cpu架构上的实现得到了证明,使其适用于实际应用。比较分析表明,aqlm可以在不影响模型性能的情况下实现极限压缩,这一点可以从其在零样本任务中的模型复杂度和准确性等指标上取得的优异结果得到证实。

谁可以从 aqlm和 pv-tuning中受益

新方法为参与开发和部署专有语言模型和开源大语言模型的公司节省了大量资源。例如,具有 130亿参数的 llama 2模型在压缩后,现在只需1个 gpu(原先需要4个)就可以运行,硬件成本降低高达8倍。这意味着初创公司、个人研究人员和大语言模型爱好者可以在他们日常使用的计算机上运行 llama等高级大语言模型。

探索新的大语言模型应用

aqlm和 pv-tuning使得在计算资源有限的设备上离线部署模型成为可能,从而为智能手机、智能音箱等提供了新的使用场景。通过集成先进的大语言模型,用户可以使用文本和图像生成、语音辅助、个性化推荐,甚至实时语言翻译,而无需激活互联网连接。

此外,因为所需的计算更少,使用这些方法压缩的模型运行速度可提高多达4倍。

实施与访问

全球的开发人员和研究人员已可以使用 aqlm和 pv-tuning,这两种大型语言模型压缩方法都可在github上获取。作者提供的演示材料为各种应用提供了有效的压缩大语言模型指导。此外,开发者还可以下载已经使用这些方法压缩过的流行开源模型。

国际机器学习大会亮点

yandex research发表的一篇关于 aqlm压缩方法的科学文章已在全球久负盛名的机器学习会议之一国际机器学习大会(icml)上发表。该文章由yandex研发团队与 ist austria的研究人员和人工智能初创公司neural magic的专家共同撰写,标志着大语言模型压缩技术的重大进步。